Auf einen Blick

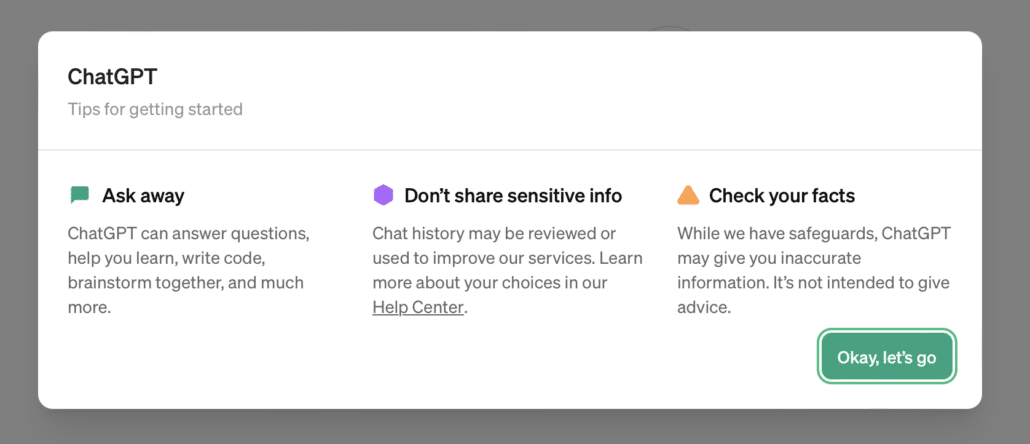

Mangelhafte Datenqualität, fehlende Transparenz, Unsicherheiten beim Datenschutz und ethische Bedenken: Der Einsatz von künstlicher Intelligenz birgt einige Risiken, die jedem bewusst sein sollten, der eine Einführung plant oder die Systeme bereits nutzt. Dieser Artikel enthält 8 wichtige Risiken mit jeweils einem Praxisbeispiel.Hast du eigentlich ein Konto bei ChatGPT? Falls ja, dann hast du sicher das prominente Pop-up direkt nach dem Registrieren gesehen:

- Ask away: Klar, stell einfach ein paar Fragen und gib der KI was zu tun.

- Don’t share sensitive info: Hier wird es schon spannender! Du sollst also aufpassen, welche Daten du in die Chats einfügst.

- Check your facts: Und du sollst dich nicht auf die Antworten verlassen.

Bereits dieses kleine Fenster zeigt, dass es beim Einsatz künstlicher Intelligenz ein paar Stolperfallen gibt, die jeder kennen sollte. In diesem Artikel gehen wir auf 8 Risiken ein, die zeigen: Alles nicht so einfach!

Dieser Artikel ist Teil 3 der Serie über KI im Projekt. Du willst mehr erfahren? Dann schau gern in die anderen Teile rein:

Teil 1: KI im Projekt –Die wichtigsten Grundlagen

Teil 2: Praktische Beispiele zum Nachvollziehen

Teil 3: 8 Risiken mit Praxisbeispielen

Teil 4: Einsatzgebiete im Projekt und anderswo

Teil 5: Werden Projektmanager überflüssig?

1. Mangelhafte Datenqualität und -integrität

Du weißt vermutlich schon: Das Ergebnis künstlicher Intelligenz (KI) steht und fällt mit guten Daten. Wenn die Datenbasis von schlechter Qualität ist, können folgende Probleme auftreten:

- Schlechte Datenqualität führt zu fehlerhaften Ergebnissen und Fehlinterpretationen in KI-Modellen (und nicht nur dort).

- KI kann aufgrund von ungenauen Daten falsche Entscheidungen treffen.

- Datenverzerrungen können dazu führen, dass KI-Systeme ungewollt diskriminierende Entscheidungen treffen.

- Schlechte Daten können bestehende Vorurteile in KI-Algorithmen verstärken.

- Heutige KI ist in der Regel nicht „selbstkritisch“, vom Benutzer gestellte Daten und Informationen werden nicht auf Konsistenz oder Vollständigkeit geprüft. Selbst wenn aufgrund dünner Datenlage keine Vorhersage möglich ist, werden die heutigen üblichen KI-Systeme eine gut formulierte und auf den ersten Blick oft überzeugende Antwort geben.

Besonders gefährlich: Ergebnisse von künstliche Intelligenz sind manchmal wie eine Fata Morgana: Sie wirken attraktiv und real – sind aber leider falsch bzw. existieren gar nicht. Nicht selten werden zum Beispiel durch die KI Studienergebnisse erfunden, um einen Text glaubhafter zu machen.

Beispiel 1:

Ein Unternehmen verwendet maschinelles Lernen, um ein Modell zur Vorhersage von Verkaufszahlen zu entwickeln. Das Modell basiert auf historischen Verkaufsdaten, die jedoch Lücken aufweisen, in denen die Informationen nicht einheitlich formatiert sind und sogar Fehler enthalten. Was passiert: Die KI gibt Empfehlungen, die keine realen Zusammenhänge widerspiegeln, sagt falsche Trends voraus und verleitet das Unternehmen zu Fehlentscheidungen.

Beispiel 2:

Ein KI-System zur medizinischen Diagnose wird mit einer Datenbasis trainiert, die schwerpunktmäßig aus „weißen US-Amerikanern mit guter privater Krankenversicherung“ besteht. Kommt dieses System für andere demographische Gruppen, klimatisch verschiedenen Regionen oder in anderen Kulturkreisen mit gänzlich anderen Lebens- und Ernährungsgewohnheiten zum Einsatz, so wird es überdurchschnittlich viele Fehldiagnosen stellen und viele Krankheitsbilder bzw. deren Ursachen nicht kennen.

Zugegebenermaßen geht es menschlichen Medizinern mit ihrer eingeschränkten Erfahrung hier nicht anders. Allerdings wird ein menschlicher Mediziner in der Regel auch nicht auf einen Schlag und zeitgleich weltweit zum Einsatz kommen.

2. Fehlende Transparenz

Oft sind KI-Modelle eine Art „Black Box“ – ihre Entscheidungen sind nicht durchschaubar. Das kann zu Vertrauensproblemen führen, besonders wenn wichtige Entscheidungen von dieser KI abhängen. Oder vertraust du einem Kollegen oder Vorgesetzten, dessen Entscheidungen für dich völlig undurchsichtig sind?

Beispiel:

Ein Unternehmen setzt in seiner Personalabteilung KI zum Bewerten von Bewerbungen ein. Das Modell wurde darauf trainiert, aufgrund von historischen Daten Muster zu erkennen und Kandidaten zu bewerten. Aufgrund der komplexen Natur des Modells ist jedoch nicht klar, wie die KI zu bestimmten Entscheidungen kommt und welche Merkmale besonders gewichtet werden. Ein qualifizierter Bewerber wird abgelehnt, und die Entscheidung des Modells bleibt undurchsichtig.

3. Zu große Abhängigkeit von Algorithmen

Was passiert, wenn sich alle auf Antworten von Systemen verlassen? Es passiert schnell, dass menschliche Intuition und Erfahrung vernachlässigt werden. Ist ja auch verführerisch: KI kann Daten unglaublich schnell analysieren und Antworten ausspucken – aber kann sie wirklich knifflige Entscheidungen fällen, bei denen es auf das menschliche Urteilsvermögen und Erfahrung ankommt?

Hinweis:

Hier geht es um Balance! Ein fähiger Mitarbeiter wird viele Aufgaben deutlich besser erledigen als eine KI. Umgekehrt wird eine gut trainierte KI einen unmotivierten und inkompetenten Mitarbeiter bei bestimmten Aufgaben um Längen schlagen.

Noch interessanter wird es bei technischen Pannen. Jedes Unternehmen sollte Strategien für Situationen auf Lager habe, in denen Algorithmen versagen oder ausfallen – technische Pannen sind schließlich nicht auszuschließen. Was passiert, wenn die KI ausfällt und ein Großteil der Mitarbeiter mit entsprechendem Wissen nicht mehr an Bord ist (Qualität) oder wenn nicht genügend Mitarbeiter vorhanden sind, um ohne KI die notwendigen Aufgaben abzuarbeiten (Kapazität)?

Beispiel:

Ein Unternehmen setzt einen KI-gesteuerten Chatbot für den Kundensupport ein, um Anfragen zu automatisieren und Kosten zu reduzieren. Der Chatbot ist allerdings nicht in der Lage, komplexe emotionale Anliegen zu verstehen oder mit ungewöhnlichen Situationen umzugehen, die menschliche Empathie und Flexibilität erfordern. Wenn sich das Unternehmen komplett auf den Chatbot verlässt, führt das zu geringer Kundenzufriedenheit und einer Verschlechterung der Servicequalität.

4. Veröffentlichung von Firmengeheimnissen

Es könnte ja so einfach sein: Du lädst ein paar Dokumente aus deinem Projekt in eine generative KI wie ChatGPT hoch und erhältst eine wunderbare Zusammenfassung. Nur … ist es überhaupt okay, firmeninterne Dokumente in die Cloud hochzuladen? Vermutlich gibt es klare Vorgaben in deinem Unternehmen, welche Daten du wie verwenden darfst.

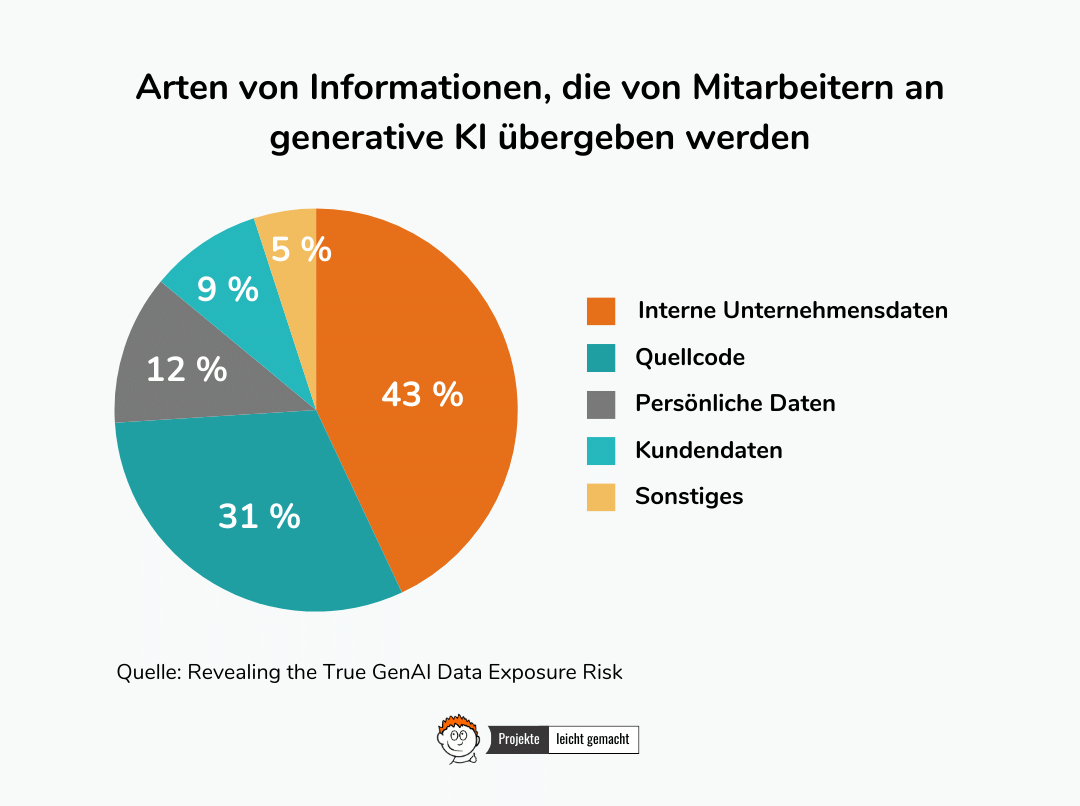

Hierzu gibt es eine schöne Untersuchung:

15 % der Angestellten posten regelmäßig Unternehmensdaten in ChatGPT. Mehr als ein Viertel dieser Daten gelten als sensible Informationen. Hier tut sich ein riesiges Sicherheitsrisiko für Arbeitgeber auf. Z.T. verwenden KI-Systeme die eingegebenen Daten, um selbst weiter zu lernen.

Quelle 1, Quelle 2

Nach dieser Befragung geraten Informationen in Umlauf, die garantiert nicht nach außen dringen sollten:

Aber auch wenn nicht Mitarbeiter selbst die Daten in KI-Chats posten, kann es zu Problemen kommen, siehe folgendes Beispiel:

Beispiel:

Ein Unternehmen implementiert ein fortschrittliches KI-System für die automatische Verarbeitung von E-Mails. Durch einen Fehler in der Konfiguration oder mangelhafte Sicherheitsvorkehrungen erkennt das KI-System nicht angemessen sensible Informationen in internen E-Mails. Als Folge könnte das System versehentlich vertrauliche Daten oder Firmengeheimnisse in externen E-Mails oder Berichten offenlegen, die nicht für die Öffentlichkeit bestimmt sind.

5. Datenschutz und Sicherheit

Viele unternehmensinterne Informationen umfassen sensible oder persönliche Daten. Bei vielen KI-Anwendungen kommt schnell die Frage auf: Ist es überhaupt in Ordnung, solche Daten verarbeiten zu lassen und darauf aufbauend Entscheidungen zu treffen? Und was passiert, wenn die Algorithmen nicht ausreichend gegen unerlaubten Zugriff abgeschirmt sind? Was ist mit Hacking-Attacken, Manipulationen und Missbrauch der Systeme?

Zugegeben: Das Thema Datensicherheit betrifft nicht nur den Einsatz von KI, sondern sollte generell weit oben in der Prioritätenliste stehen.

Beispiel:

Ein Unternehmen verwendet KI-gesteuerte Analysetools, um Mitarbeiterleistungen zu bewerten. Das System aggregiert verschiedene Datenquellen, darunter persönliche Mitarbeiterinformationen, um Leistungsmuster zu identifizieren. Selbst falls der Betriebsrat solchen Anwendungen zustimmt, besteht noch immer die Gefahr, dass sensible Mitarbeiterdaten unsachgemäß verwendet oder in unautorisierte Hände gelangen.

6. Reaktion auf unvorhersehbare Ereignisse

Wenn KI-Systeme mit neuen oder unerwarteten Themen konfrontiert werden, können sie auf unvorhersehbare Weise reagieren – hier kommt wieder das Thema „Black Box“ ins Spiel. Das ist besonders dann problematisch, wenn es um kritische Bereiche wie Medizin, Finanzen oder gar um die Sicherheit von Leib und Leben geht.

Beispiel:

Angenommen, eine KI-gesteuerte selbstfahrende Autoanwendung ist darauf trainiert, in städtischen Umgebungen zu navigieren. Plötzlich tritt ein unvorhergesehenes Ereignis auf, wie eine Straßensperrung oder ein Verkehrsunfall, der nicht in den Trainingsdaten enthalten war. Die KI könnte Schwierigkeiten haben, angemessen auf diese unerwartete Situation zu reagieren, da sie nicht darauf vorbereitet wurde.

7. Fehlende Akzeptanz durch das Team

Wie das immer beim Einführen neuer Technologien ist: Mitarbeiter müssen geschult und Strukturen angepasst werden. Solange die Mitarbeiter Chancen und Grenzen der neuen Systeme nicht verstehen, wird die Einführung nicht reibungslos klappen.

Ein weiterer kritischer Punkt: Die Automatisierung durch KI könnte in bestimmten Bereichen zum Abbau von Arbeitsplätzen führen oder eine Umstrukturierung von Arbeitsabläufen erfordern – und das bringt Unsicherheit mit sich.

Beispiel:

Nehmen wir noch einmal das Beispiel der Personalabteilung von oben auf: Die Mitarbeiter im HR-Bereich sind besorgt, dass die Automatisierung im Bewerbungsprozess ihre Rolle reduziert oder ersetzt. Die Unklarheit darüber, wie die KI-Entscheidungen getroffen werden und welche Auswirkungen dies auf die Mitarbeiter hat, führt zu Skepsis und Ablehnung.

8. Ethik und soziale Verantwortung

Wenn es keine klaren ethischen Richtlinien für den Einsatz von KI gibt, können die Technologien unverantwortlich eingesetzt werden. Unternehmen sollten sich folgende Fragen stellen:

- Wie stellen wir sicher, dass die Systeme fair arbeiten und niemanden diskriminieren?

- Wie stellen wir sicher, dass unsere Mitarbeiter als Menschen behandelt werden, nicht nur als Ressource mit Leistungsmerkmalen?

- Wie gewährleisten wir, dass ethische Überlegungen nicht den kurzfristigen Gewinnzielen geopfert werden?

- Wer trägt die volle Verantwortung für Entscheidungen, die durch ein KI-System getroffen werden oder bei denen die Entscheider durch ein KI-System in der Entscheidung unterstützt wurden?

Beispiel:

Wir schauen wieder auf das Beispiel aus der Personalabteilung, die Bewerbungen von einer KI filtern und bewerten lässt. Die Algorithmen wurden jedoch auf historischen Daten trainiert, in die unbewusste Voreingenommenheiten gegenüber bestimmten demografischen Gruppen enthalten, z. B. „Junge frisch ausgebildete Männer mit weißer Hautfarbe“. Andere Gruppen waren in den historischen Daten kaum enthalten. Infolgedessen könnte das KI-System dazu neigen, Bewerber mit ähnlichen Merkmalen zu bevorzugen und andere Gruppen zu benachteiligen. In diesem Szenario entsteht ein ethisches und soziales Problem, da der Einsatz von KI zu Diskriminierung führt und bestehende Ungleichheiten verstärken kann.

Fazit

Künstliche Intelligenz bringt eine Menge Chancen mit sich, keine Frage. Aber wie so oft gilt auch hier: Beim näheren Hinschauen offenbaren sich Stolperfallen, die allen bewusst sein sollten – idealerweise bevor eine neue Technologie eingeführt wird.